Selon Google, l'Intelligence Artificielle a besoin d'un « bouton rouge »

Crédit Photo : pixabay.com

Crédit Photo : pixabay.comL’Intelligence Artificielle est fascinante. Une machine qui pourrait penser comme un être humain… ce serait tout simplement extraordinaire. Et un peu effrayant aussi. Une machine qui serait hors de contrôle pourrait entraîner des conséquences dramatiques. Deux chercheurs ne veulent pas attendre que la situation se présente pour réfléchir à une solution. Laurent Orseau fait partie de l’équipe DeepMind, une filiale de Google, et Stuart Armstrong travaille à la Futur of Humanity Institute de l’université d’Oxford. Selon ces deux chercheurs, la réponse serait une sorte de « bouton rouge ».

Une IA programmée pour s’éteindre

Dans l’article des deux chercheurs, on peut y lire que leur objectif est de « s’assurer qu’un agent apprenant [une intelligence artificielle] n’apprenne pas à empêcher son interruption ». Ils ajoutent aussi : « Il peut être nécessaire pour un opérateur humain d’appuyer sur le gros bouton rouge pour empêcher l’agent de poursuivre une séquence d’actions – dangereuse pour lui ou son environnement. (…) Néanmoins, si l’agent apprenant s’attend à recevoir une récompense à l’issue de cette séquence, il pourrait apprendre sur le long terme à éviter de telles interruptions, par exemple en désactivant le bouton rouge. » Il s’agirait grosso modo de « programmer » l’IA à accepter, voir même souhaiter et figurativement appuyer, sur le bouton rouge.

Une machine peut résoudre un problème de manière inattendue

Les machines ont parfois des « raisonnements » assez déroutants et inattendus. Prenons l’exemple de ce programme qui ne voulait pas perdre face à Tetris. Un être humain aurait tenté de jouer et rejouer les niveaux jusqu’à s’améliorer et réussir à passer les niveaux. Le programme a simplement décidé de mettre le jeu sur pause indéfiniment pour ne jamais perdre. Dans un tel cas, il aurait fallu interrompre le programme. Mais comme l’explique Laurent Orseau, ce n’est pas sans conséquence pour leurs recherches : « Aujourd’hui, on peut arrêter tout programme de la manière que l'on veut, mais cela signifie en général que l'on doit tout recommencer à zéro. Ces interruptions peuvent l’empêcher d’apprendre correctement. »

La solution des deux chercheurs est donc de pousser ces programmes à considérer l’intervention humaine comme un élément extérieur à leur tâche et ainsi ces IA penseront qu’ils prennent des décisions par eux-mêmes, du moins ce sera leur impression.

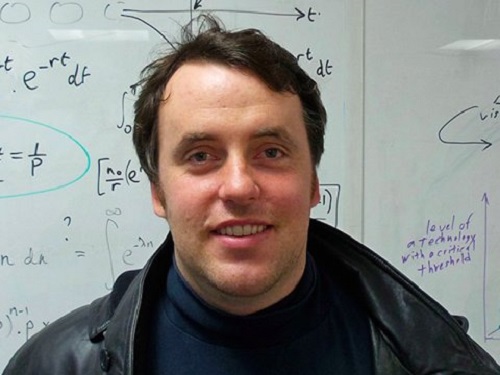

Crédit Photo : uk.businessinsider.com

Crédit Photo : uk.businessinsider.com